IA, trucaje y pornografía, ¿quién me cuida en la red?

Hace algunas semanas un grupo de estudiantes de la Facultad de Arquitectura, Urbanismo y Diseño denunció a un compañero por la edición y distribución de fotos suyas en una página porno. A partir del caso, indagamos el lado B de las tecnologías usadas para la violación a la intimidad sexual de las personas.

Hace algunas semanas, un grupo de estudiantes de la Facultad de Arquitectura, Urbanismo y Diseño (UNSJ) se enteraron: en Poringa, una conocida página porno, un perfil utilizaba fotos extraídas de sus redes sociales sin su consentimiento y ofrecía el servicio de desnudarlas mediante la utilización de un “bot”.

En un principio, comenzaron siendo 4 o 5. Al cabo de 48 horas, eran alrededor de 15 chicas las que supieron que sus fotos trucadas circulaban por Internet con fines pornográficos. Luego de indagar por cuenta propia, lograron llegar a la persona detrás del perfil. Todos los indicios apuntaban a un compañero de cursado, uno con el cual compartían aula desde hacía años. Algunas de ellas resultaron ser compañeras, pero también encontraron fotos de vecinas y hasta familiares.

“Él ofrecía un servicio que supuestamente realizaba con un bot. Publicaba una foto original sacada de nuestras redes. Desde una selfie hasta alguna en la playa, en el parque o cualquier situación, las elegía de manera aleatoria. Debajo de la original publicaba la editada donde nos desnudaba y escribía una descripción bastante morbosa”, cuenta una de las estudiantes.

“Vos scrolleabas y al final aclaraba si querés realizarle esto a una amiga o chica que conozcas, contactame. O sea, ofrecía su servicio para realizar este tipo de edición”. Servicio por el que, probablemente, cobrara.

Después de enterarse, cada una radicó su denuncia en la Unidad Fiscal de Investigación CAVIG (Centro de Abordaje de Violencia Intrafamiliar y de Género) de San Juan. Pero, frente a la dificultad de tipificar y los vacíos legales, el caso pasó al Segundo Juzgado de Faltas de la Justicia local. Cuando se trata de delitos virtuales, la legislación resulta bastante pobre.

El perfil era MarioMJohn68. Al ingresar, las chicas comprobaron que efectivamente se trataba de ellas. Lo que no pudieron saber es hacía cuánto sus fotos estaban en circulación, si eran las únicas o si es que habían más. Tampoco pudieron averiguar demasiado. Si bien lograron tomar grabaciones de pantalla y recopilar información, apenas llegó la denuncia, el dueño dio de baja el perfil que contaba con 134 seguidores al momento de ser descubierto.

Unas semanas más tarde, un juez de Garantías se encargó de darle prisión preventiva al denunciado, a quien también se le habían imputado los delitos de tenencia y distribución de pornografía infantil por distintas redes. Delito agravado por el motivo de que hay víctimas menores de 13 años.

Los trucajes, la violencia digital, la llamada sextorsión, la violación a la intimidad sexual y la divulgación de fotos sin consentimiento existen hace tiempo. La complicidad, el morbo machista y la pedofilia encuentran en Internet un lugar predilecto y discreto para desarrollarse. Alguien oferta ese contenido y hay personas dispuestas a pagar para consumirlo. Así, se conforman comunidades en las que estos delitos se cometen a diario dejando huellas imperceptibles en las capas superficiales de la red.

//Leé también: EL FUEGO QUE SUPIMOS ENCENDER

Hace un tiempo, algunos clamaban que la Inteligencia Artificial (IA) vendría a reemplazar trabajos, a dificultar los procesos de enseñanza-aprendizaje en las escuelas; a responder todas nuestras preguntas. Sin embargo, salvo en algunos casos, lo único que hemos visto es la repetición de conductas conocidas solo que ahora realizadas mediante un algoritmo con mayor rapidez y facilidad.

Estamos habituados a relacionarnos con algoritmos de todo tipo, todo el tiempo. La cuestión diferencial con la Inteligencia Artificial es lo accesible que resulta entrenar y maniobrar ese algoritmo en tiempos muy cortos. Así, podemos producir contenido que, en lo que respecta a la imagen, es difícilmente discernible de la realidad.

Ya sucedió con aquellas fotos del Papa con una puffer o de Trump siendo detenido que circularon durante días en las redes. También le sucedió a Rosalía con imágenes fakes que la mostraban a ella desnuda y a su cuerpo distorsionado. El detalle de estas fotografías artificiales es tal que, para el ojo no entrenado, pueden pasar por reales. Este fenómeno suele llamarse deepfake.

La IA, como tantas otras herramientas digitales, ofrece infinitas posibilidades que pueden explorar artistas, educadores, periodistas o diseñadores. Sin embargo, también hay quienes encuentran su utilidad para otros fines y ese riesgo deja a personas vulnerables expuestas a las violencias de siempre pero en el escenario desregulado de Internet.

¿Hasta qué punto tenemos control sobre aquello que publicamos?¿Qué responsabilidad tienen las plataformas o programas? ¿Cómo salvaguardamos nuestra privacidad? Ante la falta de regulaciones, el cuidado recae sobre los propios usuarios.

La complicidad, el morbo machista y la pedofilia encuentran en Internet un lugar predilecto y discreto para desarrollarse.

Entrenar a la IA

Para conocer acerca del funcionamiento de las inteligencias artificiales, conversamos con Nelson Cuello, artista visual y curador que investiga y trabaja la creación de imágenes digitales a través de IA.

“La IA es un algoritmo entrenado en una cantidad enorme de imágenes (más de 2 mil millones), muchas de las cuales provienen de las redes sociales o de páginas de Internet”, explica Nelson. Es decir, imágenes producidas por los propios usuarios; nosotros mismos.

El trucaje de imágenes para pornografía no es algo nuevo. Sucede desde hace mucho porque no necesita de la IA, sino que también puede realizarse con otras técnicas. “Con la pintura incluso, sin tener herramientas digitales, se podría pintar una persona desnuda sin su consentimiento. Lo mismo con Photoshop. El tema ahora es que con la IA, si bien requiere una técnica y aprender a manejar la herramienta, es mucho más accesible. Hay muchos modelos para generar imágenes pornográficas, hay hasta comunidades para estos fines”, comenta Nelson.

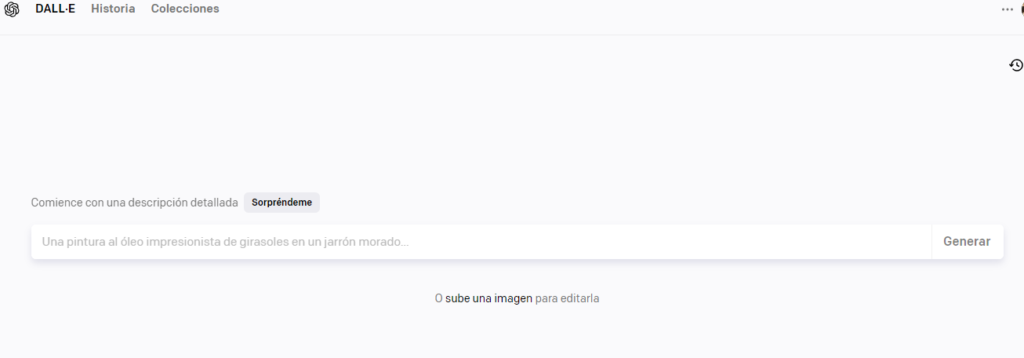

Es cierto. La creación de imágenes con IA es relativamente sencilla, aún cuando el resultado que se busque requiera de consecutiva prueba y error hasta lograr el objetivo deseado. A pesar de las particularidades de cada una, casi todas funcionan a través de un texto breve (también llamado prompt o input) en el que el creador consigna los detalles de la imagen que quiere lograr. Todas las imágenes con que se entrena una IA tienen relación con distintas palabras. Por eso, la relación entre el texto y la imagen es fundamental en el funcionamiento de esta herramienta. Detalle no menor es que la mayoría de las inteligencias operan mejor si se comanda en idioma inglés, algo que da cuenta de los sesgos del algoritmo.

Pueden hacer la prueba entrando a cualquiera de las IA más conocidas: DALL-E, Stabble Difussion, Midjourney, CivitAI, entre muchas.

El tema ahora es que con la IA, si bien requiere una técnica y aprender a manejar la herramienta, es mucho más accesible.

nelson cuello

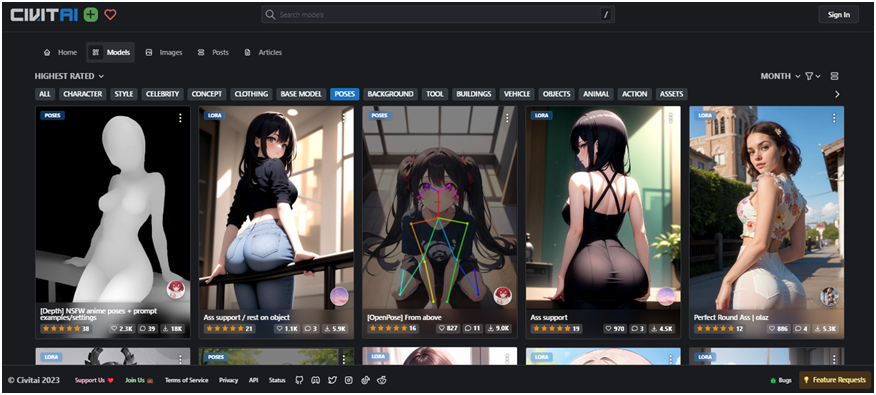

Además, las inteligencias artificiales están preconfiguradas a través de modelos generados por los mismos usuarios. Para ejemplificar de qué se trata esto, tomamos como ejemplo CivitAI. En esta IA podemos buscar diferentes modelos y observar las imágenes que nos arroja. Sin ningún tipo de configuración, aparecen mujeres con figuras prominentes, blancas, con rasgos asiáticos, en planos picados, incluso con cualidades hasta aniñadas. Ese modelo es susceptible de ser descargado y utilizado con otras imágenes. Son, como su nombre lo indica, sólo modelos.

Al respecto, Cuello dice que desde el principio de generación de imágenes con IA se viene cuestionando el sesgo ideológico que tienen estos algoritmos. “Al ser una IA, se le asigna una carga de objetividad, como si lo que dijera fuese la verdad; sucede mucho con el Chat GPT. Lo mismo pasa con las imágenes. La IA está entrenada con fotos de las personas que están en Internet, que son accesibles. Los sesgos que tenemos en las redes, como los estereotipos de belleza, se ven reflejados en estos modelos y es algo con lo que se intenta luchar en la medida en que se van generando actualizaciones, pero esto está hecho por usuarios; las IAs están entrenadas por personas”, afirma el artista.

En el caso de Stable Difussion, por ejemplo, se trata de una IA de código abierto. Esto quiere decir que permite que el usuario descargue el programa y pueda sacar algunos de los filtros que regulan la creación de imágenes o utilizar el programa sin conexión a Internet.

Si una IA puede usarse sin siquiera estar conectada a Internet, entonces ni el proveedor de servicio sería capaz de rastrear los datos de la actividad realizada ni el lugar ni la hora ni la persona responsable. Por eso, el código abierto puede resultar un arma de doble filo. Otorga libertades para la creación de contenido artístico, como entrenar el programa en la obra de un artista específico o diseñar una pieza inédita. Sin embargo, esto también implica el riesgo de la creación de contenido con fines pornográfico –entre otros- que puede ser producido sin dejar rastro y utilizando la imagen e identidad de personas sin su consentimiento. Personas que, no casualmente, resultan ser en su mayoría mujeres, niños y adolescentes.

Exactamente así, sin controles ni regulación, se realizan este tipo de actividades que pueden vulnerar la intimidad y la imagen y que, además resultan difíciles de combatir para una Justicia que no legisla a la par de los desarrollos científico-tecnologicos. Sin embargo, hay iniciativas que buscan generar regulaciones para el escenario digital porque, en muchos casos, las huellas quedan en la red y son rastreables.

Al ser una IA, se le asigna una carga de objetividad, como si lo que dijera fuese la verdad.

Grises y vacíos. ¿Cómo procede la Justicia?

El 23 de agosto la Cámara de Diputados de la Nación aprobó por amplia mayoría la media sanción de un proyecto que incorpora la violencia digital en la ley 26.485 de Protección Integral a las Mujeres. Este proyecto está basado en la “Ley Olimpia”, una ley mexicana que aborda los delitos que violan la intimidad sexual a través de medios digitales y que sanciona la difusión sin consentimiento de contenido íntimo.

Sin embargo, hasta que el proyecto sea tratado en el Senado, las denunciantes sanjuaninas se encuentran en un limbo legal. Si bien en este caso el acusado tiene prisión preventiva ya que se llegó a conocer que también distribuía pornografía infantil, de no ser por eso, sería difícil intervenir jurídicamente debido a la falta de marcos legales. Y, aunque a algunas denunciantes se les otorgó una perimetral, hubo otras que no consiguieron medidas de protección.

Lo que nos explicaron es que nosotras hemos quedado en un vacío legal. Si bien estamos al tanto del tratamiento de la Ley Olimpia, por el momento estamos desamparadas porque no estaban pudiendo encuadrar nuestro caso en ningún delito”, afirma una de las estudiantes.

Frente a la falta de contención legal, es que decidieron hacer pública la situación a los medios para “buscar algo de presión social”.

Mientras tanto, las chicas toman las medidas que están a su alcance. “Estamos poniendo nuestras cuentas privadas y teniendo cuidados pero de repente se trataba de alguien de nuestro contexto. Lo más difícil no es tanto el sentirte expuesta, sino de la fuente de la que vino”, admiten. Aún cuando el riesgo de que cualquier persona utilice nuestra imagen, los agresores suelen estar cerca.

Las víctimas no solamente están actuando en busca de respuestas jurídicas. Al hacer público su caso, también manifiestan su intención de concientizar. “Es difícil compartirlo pero más duro ha sido estar en silencio todo este tiempo”.